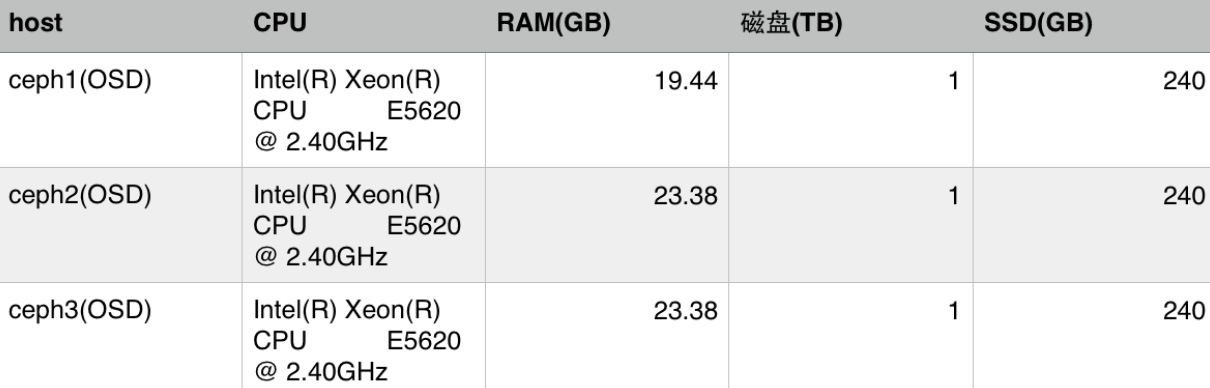

硬件环境

计算与存储

三台物理节点, 每台物理节点配备1TB 磁盘(RPM 7500, SATA2.0)和240GB SSD(SATA3.0)。

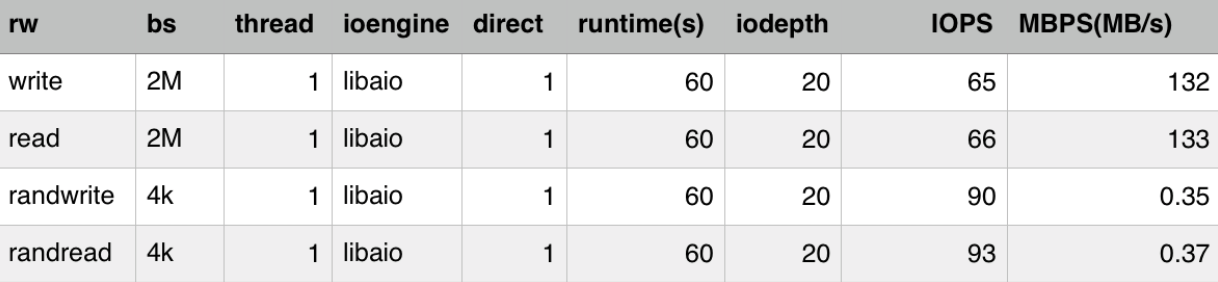

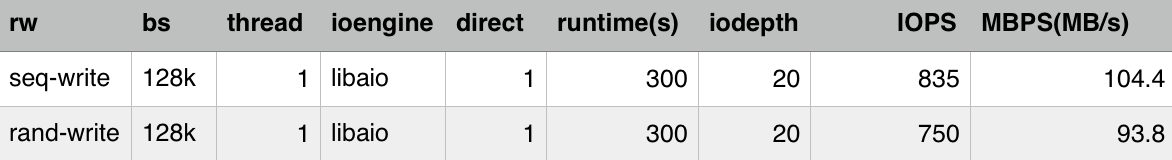

磁盘测试

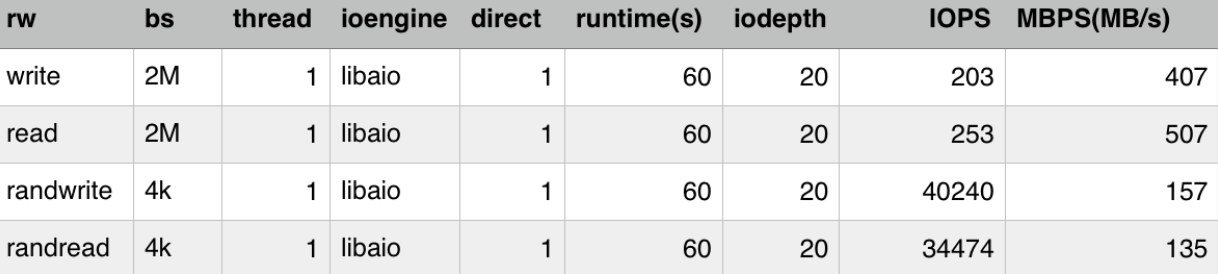

SSD测试

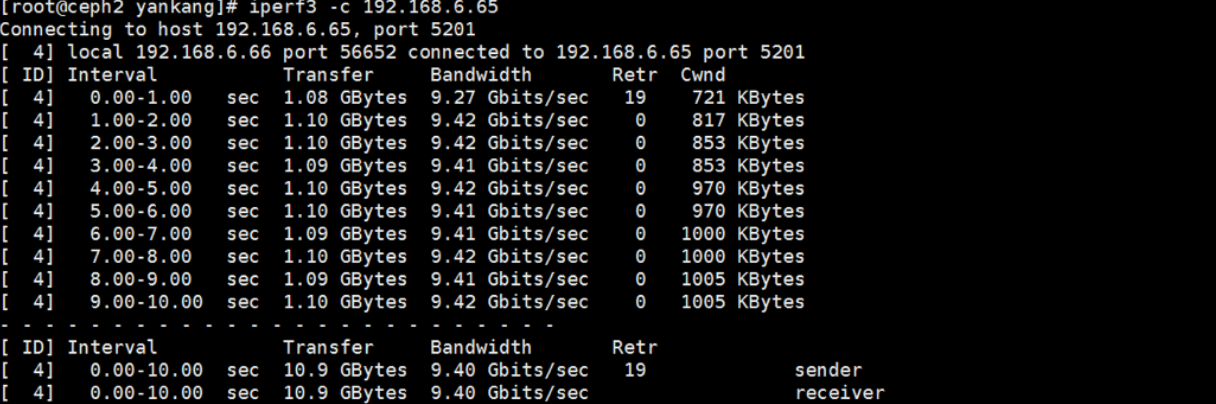

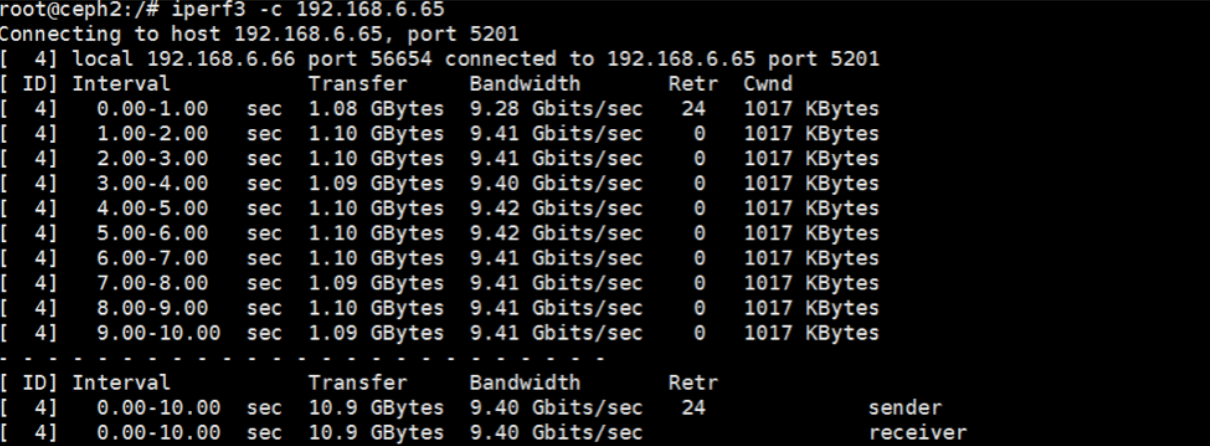

网络

三张万兆网卡,用iperf3测试物理节点间吞吐量

用iperf3测试docker之间的吞吐量,几乎没有损失

测试内容

RBD块设备

1 | # 若干有用的命令 |

fio测试

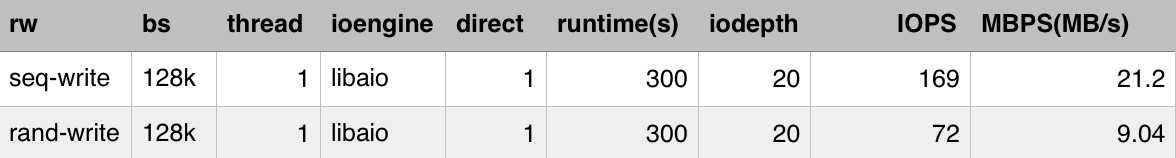

HDD-1

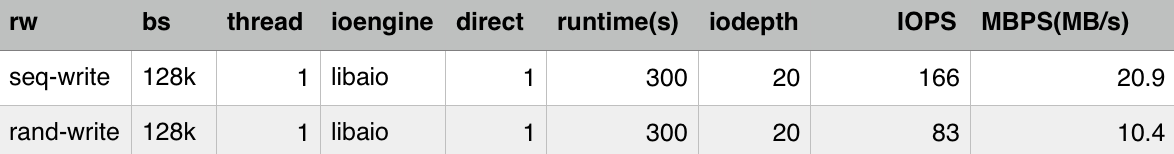

HDD-2

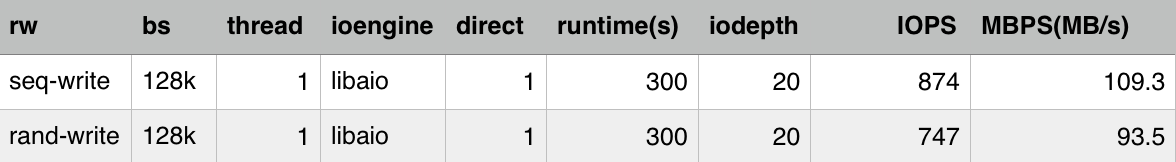

SSD-1

SSD-2

从以上四张测试结果可以看出:

- HDD-1与SSD-1的对比可以看出,SSD组建的ceph集群RBD块设备IOPS和吞吐量明显优于HDD组成的集群。

- HDD-1与HDD-2的对比可以看出,HDD-1OSD与HDD-2OSD的RBD块设备IOPS和吞吐量差异不大。

- SSD-1与SSD-2的对比可以看出,SSD-1OSD与SSD-2OSD的RBD块设备IOPS和吞吐量差异不大。

- 虚拟多OSD节点似乎更擅长处理随机写,而不怎么擅长顺序写。考虑到其他随机因素,其实差异不是很大。

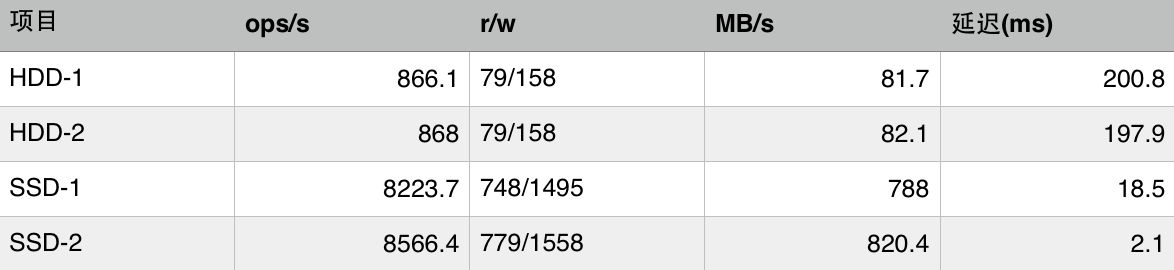

filebench

filebench测试RBD的结果

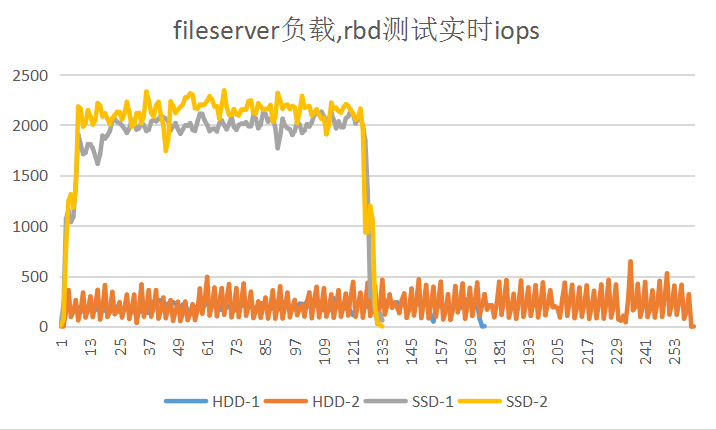

ceph集群的实时IOPS

从以上测试结果可以看出:

- HDD-1与SSD-1的对比可以看出,SSD组建的ceph集群RBD块设备明显优于HDD组成的集群。

- HDD-1与HDD-2的对比可以看出,HDD-2的实时IOPS波动比HDD-1更明显,但是HDD-1OSD与HDD-2OSD的RBD块设备性能差异不大。

- SSD-1与SSD-2的对比可以看出,SSD-2的实时IOPS略优于SSD-1,不过,整体而言,SSD-1OSD与SSD-2OSD的RBD块设备性能差异不是很明显。

cephfs分布式文件系统

1 | # 若干有用的命令 |

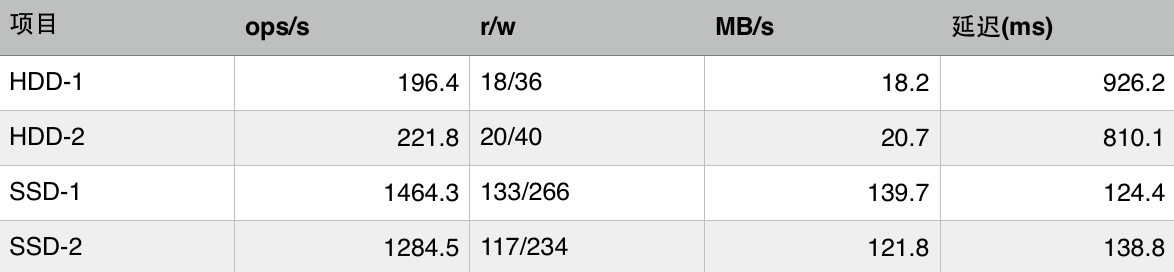

filebench测试cephfs的结果

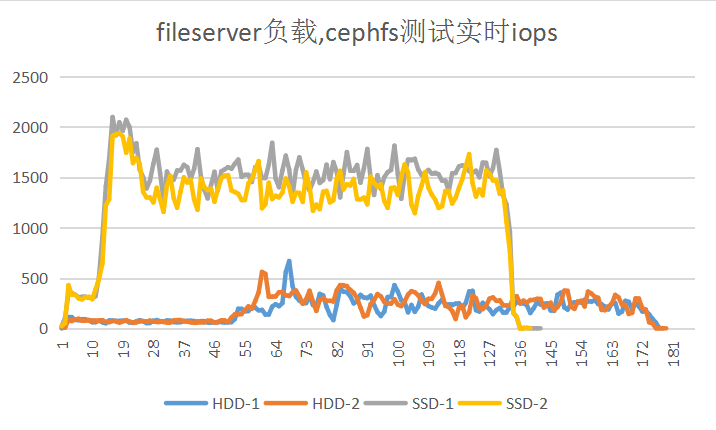

ceph集群的实时IOPS

从以上测试结果可以看出:

- HDD-1与SSD-1的对比可以看出,SSD组建的ceph集群cephfs分布式文件系统IOPS,吞吐量和IO延迟都明显优于HDD组成的集群。

- HDD-1与HDD-2的对比可以看出,HDD-1OSD与HDD-2OSD组建的ceph集群在cephfs分布式文件系统的性能差异不是很明显。

- SSD-1与SSD-2的对比可以看出,SSD-2的实时IOPS略差于SSD-1的实时IOPS,但是整体而言,SSD-1OSD与SSD-2OSD组建的ceph集群在cephfs分布式文件系统的性能差异不是很明显。